- Unter einer Wolke des Verdachts gefangen: Profiling in der EU

- Facebook beginnt, die Transparenz in politischen Anzeigen auf dem Balkan zu erhöhen

- Deutschland: Auslesen der Telefone von Flüchtlingen – Sicherheit oder Bevölkerungskontrolle?

- Verantwortungsvolle Migrationstechnik: Transparenz, Leitung und Aufsicht

- Wer sollte entscheiden, was wir online sehen?

- Sicherheitsinformationsdienst gewinnt die tschechischen Big Brother Awards

- Wir begrüßen unsere neue leitende Politikberaterin Sarah Chander!

Unter einer Wolke des Verdachts gefangen: Profiling in der EU

Von Chloé Berthélémy

Mit der schrittweisen Einführung von Gesichtserkennungstechnologien in den Polizeidienststellen in ganz Europa entlarven Anti-Rassismus-Gruppen die diskriminierende Überbewachung ethnischer Gemeinschaften in Verbindung mit dem zunehmenden Einsatz neuer Technologien durch die Strafverfolgungsbehörden. In einem Bericht des Europäischen Netzwerks gegen Rassismus (ENAR) und der Open Society Justice Initiative werden tägliche Polizeipraktiken, die durch spezifische Technologien unterstützt werden – wie Kriminalitätsanalyse, Einsatz mobiler Fingerabdruckscanner, Überwachung sozialer Medien und Mobiltelefon-Extraktion – analysiert, um ihre unverhältnismäßigen Auswirkungen auf ethnische Gemeinschaften aufzudecken.

Neben diesen lokalen und nationalen Polizeipraktiken hat die Europäische Union (EU) auch eine wichtige Rolle bei der Entwicklung von Instrumenten der polizeilichen Zusammenarbeit gespielt, die auf datengestützter Profilerstellung basieren. Unter Ausnutzung der Berichterstattung, nach der Kriminelle den Schengen- und Freizügigkeitsraum missbrauchen, rechtfertigt die EU die Massenüberwachung der Bevölkerung und Profilierungstechniken als Teil ihrer Sicherheitsagenda. Leider findet vor dem Einsatz der Technologien keine richtige demokratische Debatte statt.

Was ist Profiling in der Strafverfolgung?

Profiling ist eine Technik, bei der eine große Menge an Daten extrahiert („Data Mining“) und analysiert („Processing“) wird, um bestimmte Muster oder Verhaltensweisen zu erstellen, die zur Klassifizierung von Personen beitragen. Im Kontext von Sicherheitsrichtlinien werden einige dieser Kategorien dann als „risikobehaftet“ bezeichnet und bedürfen einer weiteren Untersuchung – entweder durch einen Menschen oder eine andere Maschine. So funktioniert sie als Filter, der auf die Ergebnisse einer allgemeinen Überwachung aller Personen angewendet wird. Sie ist die Grundlage der vorausschauenden Polizeiarbeit.

In Europa hat die datengesteuerte Profilerstellung, die hauptsächlich zu Sicherheitszwecken eingesetzt wird, unmittelbar nach Terroranschlägen wie den Anschlägen von Madrid 2004 und London 2005 zugenommen. Infolgedessen ist die EU-Politik zur Terrorismusbekämpfung und inneren Sicherheit – und die ihr zugrunde liegenden Polizeipraktiken und -instrumente – von rassistischen Annahmen geprägt, einschließlich spezifisch antimuslimischer und migrantenfeindlicher Gefühle, was zu rassistischen Profilen führt. Im Gegensatz zu dem, was Sicherheits- und Strafverfolgungsbehörden behaupten, ist die Technologie nicht immun gegen diese diskriminierenden Vorurteile und nicht objektiv in ihrem Bemühen, Verbrechen zu verhindern.

Europäische Initiativen

Die EU hat die Praxis der Profilerstellung aktiv unterstützt. Erstens verpflichten die Richtlinien zur Geldwäschebekämpfung und zur Terrorismusbekämpfung private Akteure wie Banken, Wirtschaftsprüfer und Notare, verdächtige Transaktionen, die mit Geldwäsche oder Terrorismusfinanzierung in Zusammenhang stehen könnten, zu melden und Risikobewertungsverfahren einzuführen. „Potenziell risikoreiche“ Profile werden auf der Grundlage von Risikofaktoren erstellt, die nicht immer objektiv gewählt werden, sondern auf rassistischen Vorurteilen gegenüber dem, was eine „anormale finanzielle Aktivität“ darstellt, beruhen. Infolgedessen sind unter Personen, die diesem Profil entsprechen, in der Regel Migranten, Grenzgänger und Asylsuchende überrepräsentiert.

Ein weiteres Beispiel ist die Richtlinie über Fluggastdatensätze (PNR) von 2016. Die Richtlinie verpflichtet die Fluggesellschaften, alle persönlichen Daten von Personen, die vom EU-Gebiet in Drittländer reisen, zu sammeln und sie allen EU-Mitgliedstaaten zur Verfügung zu stellen. Ziel ist es, bestimmte Kategorien von Fluggästen als „Risikopassagiere“ zu identifizieren, die einer weiteren Untersuchung bedürfen. Es gibt laufende Diskussionen über die Möglichkeit, dieses System auf den Schienenverkehr und andere öffentliche Verkehrsmittel auszuweiten.

In jüngerer Zeit hat die Vervielfältigung von EU-Datenbanken im Bereich der Migrationskontrolle und deren Vernetzung die Einbeziehung von Profilbildungstechniken zur Analyse und Auswahl „guter“ Kandidaten erleichtert. So besteht beispielsweise das Visa-Informationssystem, ein Vorschlag, der derzeit im Schnellverfahren umgesetzt wird, aus einer Datenbank, die derzeit bis zu 74 Millionen Kurz- und Langzeit-Visumanträge enthält, die anhand einer Reihe von „Risikoindikatoren“ geprüft werden. Solche „Risikoindikatoren“ bestehen aus einer Kombination von Daten, die die Altersgruppe, das Geschlecht, die Nationalität, das Land und die Stadt des Wohnsitzes, den EU-Mitgliedstaat der ersten Einreise, den Reisezweck und die derzeitige Beschäftigung umfassen. Die gleiche Logik wird im Europäischen Reiseinformations- und -genehmigungssystem (ETIAS) angewandt, einem für 2022 geplanten Instrument zur Sammlung von Daten über Drittstaatsangehörige, die für Reisen in den Schengen-Raum kein Visum benötigen. Die in diesem System verwendeten Risikoindikatoren zielen auch darauf ab, „auf Sicherheit, illegale Einwanderung oder hohe Epidemie-Risiken hinzuweisen“.

Warum sind die Grundrechte in Gefahr?

Die Profiling-Praktiken beruhen auf der massiven Sammlung und Verarbeitung personenbezogener Daten, die ein großes Risiko für das Recht auf Privatsphäre und Datenschutz darstellen. Da die meisten polizeilichen Instrumente ein öffentliches Sicherheitsinteresse verfolgen, werden sie als legitim angesehen. Allerdings erfüllen nur wenige tatsächlich die Anforderungen an Transparenz und Rechenschaftspflicht und sind daher schwer zu überprüfen. Die in der EU-Grundrechtscharta vorgeschriebenen wesentlichen Rechtmäßigkeitsprüfungen der Notwendigkeit und Verhältnismäßigkeit können nicht durchgeführt werden: nur eine konkrete Gefahr – nicht die Möglichkeit einer solchen – kann Eingriffe in das Recht auf Achtung des Privatlebens und den Datenschutz rechtfertigen.

Insbesondere sind die Kriterien, anhand derer bestimmt wird, welche Profile einer weiteren Prüfung bedürfen, undurchsichtig und schwer zu bewerten. Die Fragen sind: Welche Kategorien und welche Daten werden ausgewählt und ausgewertet? Von wem werden sie ausgewählt und bewertet? Im Zusammenhang mit dem ETIAS-System betonte die EU-Grundrechtsagentur, dass die Möglichkeit, Risikoindikatoren zu verwenden, ohne bestimmte Kategorien von Personen im Transit zu diskriminieren, unklar sei, und empfahl daher, den Einsatz von Profilerstellungstechniken zu verschieben. Die Verallgemeinerung ganzer Personengruppen auf der Grundlage bestimmter Gründe ist definitiv etwas, das gegen das Recht auf Nichtdiskriminierung zu prüfen ist. Darüber hinaus ist es problematisch, dass die Aufgaben der Bewertung und Überwachung der Profilerstellungspraktiken an „Beratungs- und Lenkungsgremien“ vergeben werden, die von Strafverfolgungsbehörden wie Frontex eingerichtet werden. Es ist sehr problematisch, Datenschutzaufsichtsbehörden und demokratische Aufsichtsgremien von diesem Prozess auszuschließen.

Wenn mehrere neutrale Merkmale oder Verhaltensweisen zu Anzeichen eines unerwünschten oder sogar zu misstrauendem Profil werden, kann dies dramatische Folgen für das Leben von Einzelpersonen haben. Die Folgen der Übereinstimmung Ihrer Merkmale mit einem „verdächtigen Profil“ können zu Einschränkungen Ihrer Rechte führen. Zum Beispiel kann im Bereich der Terrorismusbekämpfung Ihr Recht auf wirksame Rechtsmittel und ein faires Verfahren behindert werden, da Sie sich in der Regel nicht bewusst sind, dass Sie aufgrund einer Übereinstimmung im System unter Beobachtung gestellt wurden, und Sie sich nicht in der Lage sehen, eine solche Maßnahme anzufechten.

Da die Strafverfolgungsbehörden in ganz Europa zunehmend Profilbildungspraktiken anwenden, ist es von entscheidender Bedeutung, dass materielle Schutzmaßnahmen eingeführt werden, um die vielen Gefahren für die Rechte und Freiheiten des Einzelnen, die sie mit sich bringen, zu mindern.

Weitere Informationen:

Datengesteuerte Polizeiarbeit: die feste Verkabelung diskriminierender Polizeipraktiken in ganz Europa (PDF, 19.11.2019)

Neuer Rechtsrahmen für die prädiktive Polizeiarbeit in Dänemark (22.02.2017)

Facebook beginnt, die Transparenz in politischen Anzeigen auf dem Balkan zu erhöhen

Von der SHARE-Stiftung

Facebook hat angekündigt, dass es ab Mitte März sein Transparenzsystem und die Bestätigung der Authentizität von Anzeigen über Wahlen und Politik ausweiten wird. Nämlich wird Facebook 32 weitere Länder abdecken, darunter Serbien und Nord-Mazedonien, wo die Wahlen sehr bald stattfinden werden.

Diese Wende folgt auf die Bemühungen des EDRi-Mitglieds SHARE Foundation und seiner internationalen Partner, Vertreter von Facebook auf das Problem hinzuweisen, dass die Westbalkanländer von den Ländern ausgeschlossen sind, in denen Facebook politische Werbung aktiv überwacht. Dieses Thema ist angesichts der Wahlkampagnen in Serbien und Nordmazedonien sehr wichtig, wenn man mögliche Manipulationen, die fehlende Transparenz der Finanzierung von Anzeigen und die Nutzung unpolitischer Seiten zur Werbung für politische Zwecke bedenkt.

Facebook wird auf diese Weise die Transparenz der politischen Werbung auf ihrer wichtigsten sozialen Netzwerkplattform und Instagram in den oben genannten Ländern erweitern. Bisher wurden solche Maßnahmen vor allem wegen des Verdachts auf ausländische Einmischung in den Wahlprozess während der US-Präsidentschaftswahlen und des Brexit-Referendums 2016 umgesetzt. Der Cambridge-Analytica-Skandal, bei dem Daten von mehreren zehn Millionen Bürgern durchsickerten und Druck von Seiten der Staaten ausgeübt wurde, setzte auch Facebook unter Druck, die Transparenz seiner Plattform zu verbessern.

Die Facebook-Werbebibliothek wird Informationen über die gesamten Werbeausgaben, die Anzahl der Anzeigen sowie Daten über spezifische Anzeigen – demografische Zielgruppe der Anzeige, geografische Reichweite der Anzeige usw. – zur Verfügung stellen. Um politische Werbung zu analysieren, wird Facebook Forschern, Journalisten und der Öffentlichkeit den Zugang zur API der Anzeigenbibliothek ermöglichen. Darüber hinaus wird es bis Ende April möglich sein, einen Bericht für die neuen 32 Länder mit aggregierten Daten über Anzeigen zu Wahlen und Politik herunterzuladen.

Alle Akteure, einschließlich politischer Parteien, Kandidaten und anderer Organisationen, die Anzeigen zu Wahlen oder Politik auf Facebook und Instagram schalten möchten, müssen sich als Werbetreibende registrieren lassen, damit man sehen kann, wer für die Anzeigen bezahlt hat. Außerdem müssen Werbetreibende die Identität mit offiziellen Dokumenten des Staates, in dem sie Anzeigen veröffentlichen möchten, sowie zusätzliche Informationen wie lokale Adresse, Telefonnummer, E-Mail und Website bestätigen, wenn sie den Namen einer Facebook-Seite oder Organisation im Haftungsausschluss verwenden möchten. Falls sie sich nicht registrieren, kann Facebook das Veröffentlichen von Anzeigen zu Politik und Wahlen während des Verifizierungsprozesses einschränken.

Weitere Informationen:

Facebook beginnt, Wahl- und politische Werbung auf dem Balkan zu verfolgen (09.03.2020)

Beitrag von Bojan Perkov, EDRi-Mitglied SHARE Foundation

Deutschland: Auslesen der Telefone von Flüchtlingen – Sicherheit oder Bevölkerungskontrolle?

Von der Gesellschaft für Freiheitsrechte

In seiner neuen Studie untersucht das EDRi-Mitglied Gesellschaft für Freiheitsrechte (GFF), wie deutsche Behörden die Telefone von Flüchtlingen aufspähen. Ziel der „Datenträgerauswertung“ soll es sein, die Identität einer Person und ihr Herkunftsland zu ermitteln. In Wirklichkeit verletzt sie jedoch die Rechte von Flüchtlingen und liefert keine aussagekräftigen Ergebnisse.

Kann ein Asylsuchender in Deutschland keinen Pass oder Passersatzpapiere vorlegen, ist das Bundesamt für Migration und Flüchtlinge (BAMF) berechtigt, eine „Datenträgerauswertung“ durchzuführen, d.h. Daten aus den Telefonen und anderen Geräten des Asylsuchenden zu extrahieren und zu analysieren, um die angegebene Herkunft und Identität des Inhabers zu überprüfen. Zu den Daten, die analysiert werden, gehören die Ländervorwahlen ihrer Kontakte, ein- und ausgehende Anrufe und Nachrichten, die Browser-Historie, Geodaten von Fotos sowie E-Mail-Adressen und Benutzernamen, die in Anwendungen wie Facebook, booking.com oder Dating-Apps verwendet werden. Insbesondere führt das BAMF diese Datenanalyse ungeachtet des konkreten Verdachts durch, dass die Asylsuchenden unwahre Angaben zu ihrer Identität oder ihrem Herkunftsland gemacht haben.

Die Studie „Invasion von Flüchtlingstelefonen: Digitale Formen der Migrationskontrolle“ untersucht und bewertet, wie das BAMF die Daten von Flüchtlingen auswertet und welche Art von Ergebnissen die Datenträgerauswertung bisher erbracht hat. Für die Studie haben die Journalistin Anna Biselli und die GFF-Anwältin Lea Beckmann zahlreiche Quellen umfassend recherchiert und ausgewertet. Dazu gehören unter anderem Datenträger-Auswertungsberichte, Asylakten, BAMF-interne Regelungen, wie z.B. ein Benutzerhandbuch zum Lesen mobiler Datenträger, und Schulungsunterlagen für BAMF-Mitarbeiter sowie Informationen, die durch parlamentarische Anfragen öffentlich gemacht wurden.

Hohe Kosten, nutzlose Ergebnisse

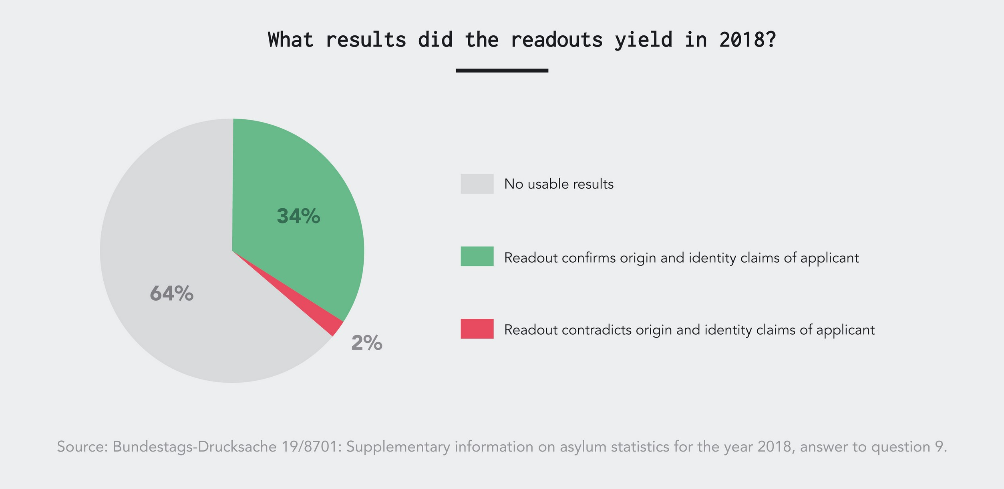

Die Studie ergab, dass die Auswertung von Datenträgern kein wirksames Mittel zur Feststellung der Identität und des Herkunftslandes einer Person ist. Seit Beginn der Datenträgerauswertung im Jahr 2017 hat das BAMF rund 20.000 Mobiltelefone von Asylsuchenden untersucht. Wenn die Einmischung in die Privatsphäre von Flüchtlingen durch die Datenträgerauswertung zu Ergebnissen führt, bestätigt sie in der Regel nur das, was die Personen selbst in ihren Interviews mit BAMF-Mitarbeitern angegeben haben.

Im Jahr 2018 ergaben nur 2% der erfolgreichen Datenträgerauswertungen Widersprüche zu den Aussagen der Asylsuchenden. Abbildung: GFF/Julia Zé

Schon vor der Verabschiedung des Gesetzes zur besseren Durchsetzung der Ausreisepflicht bestanden Zweifel an der Wirksamkeit der Datenträgerauswertung. Das Gesetz zielt darauf ab, Abschiebungen zu beschleunigen. Mit der Einführung der Datenträgerauswertung erhoffte sich der Gesetzgeber eine schnellere Überprüfung der Identität, des Herkunftslandes und der Schutzgründe einer Person als bisher. In der Praxis hat das Verfahren diese Erwartungen nicht erfüllt. Es hat sich auch als sehr teuer erwiesen.

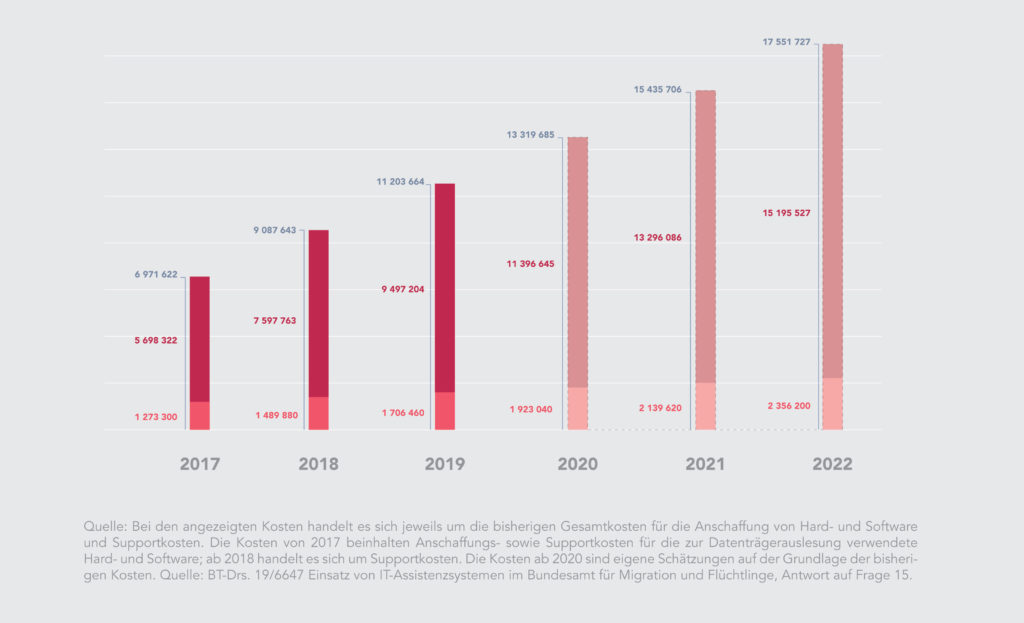

Im Verhältnis zum begrenzten Nutzen der Datenträgerauswertung sind die Kosten des Verfahrens eindeutig unverhältnismäßig hoch. Das Bundesinnenministerium hat im Februar 2017 mitgeteilt, dass mit Einrichtungskosten in Höhe von 3,2 Millionen Euro zu rechnen ist. Bis Ende 2018 seien jedoch bereits 7,6 Millionen Euro für das System ausgegeben worden, mehr als doppelt so viel wie ursprünglich veranschlagt.

Gesamtkosten des BAMF für das Lesen und Auswerten der Datenträger: Von knapp 7 Millionen Euro im Jahr 2017 auf voraussichtlich 17 Millionen Euro im Jahr 2022. Abb: GFF/Julia Zé

Eine eklatante Verletzung der Grundrechte

Die Überprüfung der Telefone von Flüchtlingen kann als eine Menschenrechtsverletzung angesehen werden. Trotzdem hat Deutschland Millionen von Euro für die Einführung und Weiterentwicklung dieser Praxis ausgegeben. Mit der Auswertung von Datenträgern wird das Grundrecht auf informationelle Selbstbestimmung, das das Bundesverfassungsgericht festgelegt hat, umgangen. Flüchtlinge unterliegen dem Datenschutz zweiter Klasse. Zugleich sind sie besonders verletzlich und haben keinen sinnvollen Zugang zu Rechtsmitteln.

Deutschland ist nicht das einzige Land, das mit digitalen Formen der Migrationskontrolle experimentiert. Der Ansatz des BAMF ist Teil eines breiteren, internationalen Trends zur Erprobung neuer Überwachungs- und Kontrolltechnologien an marginalisierten Bevölkerungsgruppen, darunter auch an Flüchtlingen. Einzelne Menschen sowie ihre individuelle Geschichte werden zunehmend auf Datensätze reduziert. Das GFF wird diesem Trend mit rechtlichen Mitteln entgegenwirken: Gegen die Auswertung der Datenträger durch das BAMF bereiten wir derzeit rechtliche Schritte vor.

Wir danken dem Digital Freedom Fund für seine Unterstützung.

Weitere Informationen:

Gesellschaft für Freiheitsrechte (GFF, Gesellschaft für Bürgerrechte)

Eindringen in die Telefone der Flüchtlinge: Digitale Formen der Migrationskontrolle (PDF)

Die menschenrechtlichen Auswirkungen von Technologien zur Migrationskontrolle (12.02.2020)

Einwanderung, Iris-Scanning und iBorderCTRL (26.02.2020)

Beitrag des EDRi-Mitglieds Gesellschaft für Freiheitsrechte – GFF, Deutschland

Verantwortungsvolle Migrationstechnik: Transparenz, Leitung und Aufsicht

Von Petra Molnar

Migration beherrscht weiterhin die Schlagzeilen in der ganzen Welt. Angesichts der sich derzeit verschlechternden Situation an der Grenze zwischen Griechenland und der Türkei, mit Berichten über zunehmend repressive Maßnahmen zur Abweisung von Menschen, spielen neue Technologien bereits eine Rolle bei der Grenzüberwachung und der Entscheidungsfindung an der Grenze.

In unseren beiden letzten Blogposts haben wir untersucht, wie weitreichend die Technologien zur Migrationskontrolle tatsächlich sind. Von Flüchtlingslagern über Grenzräume bis hin zu Anhörungsräumen der Einwanderungsbehörde sehen wir den Anstieg automatisierter Entscheidungshilfen, die menschliche Beamte ersetzen, die Entscheidungen über Ihre Migrationsreise treffen. Der Einsatz dieser Technologien öffnet auch die Tür für Verletzungen der Rechte von Migranten.

Wie wirken sich diese Technologien der Migrationskontrolle auf die Grundrechte aus und was können wir dagegen tun?

Leben und Freiheit

Wir sollten die weitreichenden Auswirkungen der neuen Technologien auf das Leben und die Sicherheit von Menschen, die unterwegs sind, nicht unterschätzen. Das Recht auf Leben und Freiheit ist eines der grundlegendsten international geschützten Rechte und für Migrations- und Flüchtlingskontexte von großer Bedeutung. Zahlreiche technologische Experimente berühren bereits das Recht auf Leben und Freiheit. Das deutlichste Beispiel ist die Verweigerung der Freiheit, wenn Menschen in Haft genommen werden. Die Inhaftierung von Einwanderern ist in hohem Maße eine Ermessensfrage. Die Rechtfertigung einer verstärkten Inhaftierung auf der Grundlage manipulierter Algorithmen, wie z.B. an der Grenze zwischen den USA und Mexiko, zeigt, wie weit wir bereit sind, Eingriffe in grundlegende Menschenrechte unter dem Deckmantel der nationalen Sicherheit und der Durchsetzung der Grenzen zu rechtfertigen. Fehler, Fehlkalibrierungen und Mängel bei den Ausbildungsdaten (für KI gestützte Systeme) können zu tiefgreifenden Verletzungen der Rechte, der Sicherheit und der Freiheit von Migranten führen, wenn sie unrechtmäßig inhaftiert werden. Beispielsweise können Aspekte von Ausbildungsdaten, die in der Realität nur Zufälle sind, von einem maschinellen Lernsystem als relevante Muster behandelt werden, was zu Ergebnissen führt, die als willkürlich angesehen werden. Dies ist ein Grund, warum die Allgemeine Datenschutzverordnung der EU (GDPR) die Fähigkeit verlangt, nachzuweisen, dass die bei der algorithmischen Entscheidungsfindung angewandten Korrelationen „legitime Rechtfertigungen für die automatisierten Entscheidungen“ sind.

Gleichheitsrechte und Diskriminierungsfreiheit

Gleichheit und Diskriminierungsfreiheit sind integraler Bestandteil der Menschenwürde, insbesondere in Situationen, in denen häufig negative Rückschlüsse auf Randgruppen gezogen werden. Algorithmen sind anfällig für dieselben Probleme bei der Entscheidungsfindung, die menschliche Entscheidungsträger plagen: Transparenz, Verantwortlichkeit, Diskriminierung, Voreingenommenheit und Fehler. Die undurchsichtige Natur der Entscheidungsfindung bei der Einwanderungs- und Flüchtlingspolitik schafft ein Umfeld, das reif ist für algorithmische Diskriminierung. Entscheidungen in diesem System – von der Frage, ob die Lebensgeschichte eines Flüchtlings „wahrheitsgetreu“ ist, bis hin zur Frage, ob die Ehe eines zukünftigen Einwanderers „echt“ ist – sind in hohem Maße ermessensabhängig und hängen oft von der Beurteilung der Glaubwürdigkeit einer Person ab. Was wird beim experimentellen Einsatz von KI-Lügendetektoren auf EU-Flughäfen als Wahrhaftigkeit angesehen und wie wird mit Unterschieden in der interkulturellen Kommunikation umgegangen, um sicherzustellen, dass problematische Schlussfolgerungen nicht in das System kodiert und verstärkt werden? Die Komplexität der Migration – und der menschlichen Erfahrung – lässt sich nicht einfach auf einen Algorithmus reduzieren.

Rechte auf Privatsphäre

Die Privatsphäre ist nicht nur ein Verbraucher- oder Eigentumsinteresse: Sie ist ein Menschenrecht, das in den grundlegenden demokratischen Prinzipien der Würde und Autonomie verwurzelt ist. Wir müssen die unterschiedlichen Auswirkungen von Verletzungen der Privatsphäre berücksichtigen, wenn wir die Erfahrungen von Menschen unterwegs betrachten. Wenn gesammelte Informationen mit repressiven Regierungen, vor denen Flüchtlinge fliehen, geteilt werden, können die Auswirkungen lebensbedrohlich sein. Oder, wenn automatisierte Entscheidungssysteme, die die sexuelle Orientierung einer Person vorhersagen sollen, von Staaten infiltriert werden, die auf die LGBTQI+-Gemeinschaft abzielen, wird es wahrscheinlich zu Diskriminierungen und Bedrohungen für Leben und Freiheit kommen. Ein an der Stanford University entwickelter Gesichtserkennungsalgorithmus hat bereits versucht, die sexuelle Orientierung einer Person auf Fotos zu erkennen. Dieser Einsatz von Technologie hat besondere Auswirkungen auf den Flüchtlings- und Einwanderungskontext, wo Asylanträge aufgrund der sexuellen Orientierung oft darauf beruhen, dass man seine Verfolgung auf der Grundlage veralteter Maßstäbe für nicht-heteronormatives Verhalten nachweisen muss. Deshalb ist der Schutz der Privatsphäre der Menschen für ihre Sicherheit und ihr Wohlergehen von höchster Bedeutung.

Verfahrensgerechtigkeit

Wenn wir über die Menschenrechte von Menschen auf der Flucht sprechen, müssen wir auch die Grundsätze der Verfahrensgerechtigkeit berücksichtigen, die sich darauf auswirken, wie der Antrag einer Person geprüft und bewertet wird und wie ein ordnungsgemäßes Verfahren in einem zunehmend automatisierten Kontext aussieht.

Bei der Entscheidungsfindung in den Bereichen Einwanderung und Flüchtlinge beispielsweise schreibt die Verfahrensgerechtigkeit vor, dass die von Verwaltungsverfahren betroffene Person das Recht hat, gehört zu werden, das Recht auf einen fairen, unparteiischen und unabhängigen Entscheidungsträger, das Recht auf eine Begründung – auch bekannt als das Recht auf eine Erklärung – und das Recht, gegen eine ungünstige Entscheidung Rechtsmittel einzulegen. Es ist jedoch unklar, wie das Verwaltungsrecht mit der Erweiterung oder gar Ersetzung menschlicher Entscheidungsträger durch Algorithmen umgehen wird.

Während diese Technologien oft als Werkzeuge für menschliche Entscheidungsträger dargestellt werden, ist die Grenze zwischen maschineller und menschlicher Entscheidungsfindung oft unklar. Angesichts der anhaltenden Verzerrung durch Automatisierung oder der Neigung, automatisierte Entscheidungen als genauer und fairer zu betrachten, welche Rubriken werden menschliche Entscheidungsträger verwenden, um zu bestimmen, wie viel Gewicht den algorithmischen Vorhersagen im Gegensatz zu allen anderen ihnen zur Verfügung stehenden Informationen, einschließlich ihres eigenen Urteils und ihrer eigenen Intuition, beizumessen ist? Wenn etwas schief geht und Sie eine algorithmische Entscheidung anfechten wollen, wie werden wir dann entscheiden, was als vernünftige Entscheidung gilt? Es ist nicht klar, wie die Gerichte und Gerichte mit der automatisierten Entscheidungsfindung umgehen werden, welche Überprüfungsstandards verwendet werden und wie die Rechtsmittel oder Berufungen für Menschen aussehen werden, die unkorrekte oder diskriminierende Entscheidungen anfechten wollen.

Was wir brauchen: Kontextspezifische Steuerung und Kontrolle

Technologie repliziert Macht in der Gesellschaft, und ihre Vorteile werden nicht in gleicher Weise erfahren. Dennoch gibt es derzeit kein globales Regelwerk, das den Einsatz neuer Technologien bei der Steuerung der Migration überwacht. Ein großer Teil der technologischen Entwicklung findet in so genannten „Black Boxes“ statt, in denen die Gesetze über geistiges Eigentum und eigentumsrechtliche Erwägungen die Öffentlichkeit davon abhalten, die Funktionsweise der Technologie vollständig zu verstehen.

Während Gespräche über die Ethik der künstlichen Intelligenz (KI) geführt werden, geht die Ethik nicht weit genug. Wir brauchen einen schärferen Fokus auf Aufsichtsmechanismen, die auf grundlegenden Menschenrechten basieren und die das hohe Risiko der Entwicklung und des Einsatzes von Technologien zur Migrationskontrolle anerkennen. Betroffene Gemeinschaften müssen ebenfalls in diese Gespräche einbezogen werden. Anstatt mehr Technologie „für“ oder „über“ Flüchtlinge und Migranten zu entwickeln und riesige Datenmengen zu sammeln, sollten Menschen, die selbst Vertreibung erlebt haben, im Mittelpunkt der Diskussionen darüber stehen, wann und wie neue Technologien in Flüchtlingslager, in die Grenzsicherung oder in Flüchtlingsanhörungen integriert werden sollten – wenn überhaupt.

Als Ausgangspunkt sollten Staaten und internationale Organisationen, die Technologien zur Migrationskontrolle entwickeln und einsetzen, zumindest einen Ausgangspunkt haben:

• sich zu Transparenz verpflichten und öffentlich berichten, welche Technologie entwickelt und eingesetzt wird und warum;

• verbindliche Richtlinien und Gesetze verabschieden, die mit international geschützten grundlegenden Menschenrechtsverpflichtungen übereinstimmen und die das hohe Risiko von Migrationskontrolltechnologien anerkennen;

• ein unabhängiges Gremium einrichten, das den gesamten Einsatz automatisierter Technologien bei der Migrationssteuerung überwacht und überprüft;

• Gespräche zwischen politischen Entscheidungsträgern, Akademikern, Technologen, der Zivilgesellschaft und den betroffenen Gemeinschaften über die Risiken und Versprechungen des Einsatzes neuer Technologien zu fördern.

Bleiben Sie in den nächsten Monaten auf dem Laufenden, um sich über Updates zu unserem KI- und Migrationsprojekt zu informieren, während wir die gelebten Erfahrungen von Menschen dokumentieren, die unterwegs sind und von Technologien der Migrationssteuerung betroffen sind. Wenn Sie mehr über dieses Projekt erfahren möchten oder Feedback und Ideen haben, wenden Sie sich bitte an petra.molnar [at] utoronto [dot] ca.

Weitere Informationen:

Mozilla-Fellow Petra Molnar arbeitet mit uns an KI & Diskriminierung (26.09.2020)

Die menschenrechtlichen Auswirkungen von Technologien zur Migrationskontrolle (12.02.2020)

Einwanderung, Iris-Scanning und iBorderCTRL (26.02.2020)

Die Privatisierung der Migrationskontrolle (24.02.2020)

Besprechung: Eine fingierte Flüchtlingskrise an der griechisch-türkischen Grenze (04.03.2020)

Clearviews App zur Gesichtserkennung wurde vom Justizministerium, ICE, Macy’s, Walmart und der NBA verwendet (27.02.2020)

Warum Gesichter nicht immer die Wahrheit über Gefühle sagen (26.02.2020)

Beitrag, Petra Molnar, Mozilla-Stipendiatin, EDRi

Wer sollte entscheiden, was wir online sehen?

Von Access Now

Online-Plattformen rangieren und moderieren Inhalte, ohne uns mitzuteilen, wie und warum sie dies tun. Es besteht ein dringender Bedarf an Transparenz der Praktiken und Politiken dieser Online-Plattformen.

Unser Leben ist eng mit der Technologie verflochten. Ein offensichtliches Beispiel dafür ist, wie wir im Internet surfen, lesen und kommunizieren. In diesem Artikel diskutieren wir zwei Methoden, die Unternehmen anwenden, um Ihnen Inhalte zu liefern: Ranking und Moderation.

Ranking-Inhalte

Plattformen verwenden automatisierte Maßnahmen zur Einstufung und Moderation der von uns hochgeladenen Inhalte. Wenn Sie während der Arbeitspausen nach diesen Katzenvideos suchen, wird Ihr Suchergebnis nicht jedes Katzenvideo online anbieten. Das Ergebnis hängt von Ihrem Standort, Ihren Spracheinstellungen, Ihren letzten Suchanfragen und allen Daten ab, die die Suchmaschine über Sie besitzt.

Die Dienste kuratieren und ordnen die Inhalte, während sie unsere persönlichen Vorlieben und unser Online-Verhalten vorhersagen. Auf diese Weise beeinflussen sie nicht nur unseren Zugang zu Informationen, sondern auch die Art und Weise, wie wir unsere Meinung bilden und am öffentlichen Diskurs teilnehmen. Indem sie unsere Präferenzen vorhersagen, formen sie diese auch und verändern langsam unser Online-Verhalten.

Sie haben eine entscheidende Rolle bei der Bestimmung dessen, was wir lesen und sehen. Es ist, als wäre man auf einer Tournee in einem fremden Land, wo nur der Reiseführer die Sprache spricht. Und der Reiseführer kann wählen, was Sie sehen und mit wem Sie sprechen. In ähnlicher Weise entscheiden diese Online-Dienste, was Sie sehen. Durch die Verstärkung und Quantifizierung der Popularität bestimmter Arten von sensationellen Inhalten, die das Engagement fördern, begleitet von den oft unvorhersehbaren Nebenwirkungen der algorithmischen Personalisierung, ist das Inhalts-Ranking zu einer Ware geworden, von der die Plattformen profitieren. Darüber hinaus kann dies zu einer Manipulation Ihrer Meinung führen. Die Freiheit der Meinungsbildung ist jedoch ein absolutes Recht, was bedeutet, dass kein Eingriff in diese Freiheit gesetzlich erlaubt ist und von keiner demokratischen Gesellschaft akzeptiert werden kann.

Die automatisierte Kuratierung unserer Inhalte bestimmt, welche Art von Informationen wir erhalten, und hat einen starken Einfluss darauf, wie viel Zeit wir mit dem Surfen auf der Plattform verbringen. Die meisten von uns haben nicht genügend Informationen darüber, wie Empfehlungsalgorithmen die Hierarchisierung von Inhalten im Internet bilden, und viele wissen nicht einmal, dass es eine Rangfolge gibt. Die sinnvolle Transparenz der Kurationsmechanismen ist eine Voraussetzung dafür, dass die Nutzer über die Werkzeuge, die unsere Informationslandschaft mitgestalten, verfügen können. Wir müssen wissen, wann wir einer automatisierten Entscheidungsfindung unterworfen werden, und wir haben das Recht, nicht nur eine Erklärung abzugeben, sondern auch Einwände dagegen zu erheben. Um unsere Handlungsfähigkeit gegenüber der Kuratierung von Inhalten zurückzugewinnen, brauchen wir Online-Plattformen, die sinnvolle Transparenzanforderungen umsetzen. Robuste Transparenz und Erklärbarkeit automatisierter Maßnahmen sind Voraussetzungen für die Ausübung unserer Rechte auf Redefreiheit, damit wir effektiv gegen unangemessene inhaltliche Einschränkungen Einspruch erheben können

Inhaltliche Moderation

Online-Plattformen kuratieren und moderieren, um bei der Bereitstellung von Informationen zu helfen. Sie tun dies auch deshalb, weil die Gesetzgeber auf EU- und nationaler Ebene ihnen immer mehr Verantwortung auferlegen, die von Nutzern hochgeladenen Inhalte zu überwachen, wobei ihnen oft hohe Geldstrafen drohen. Nach dem europäischen Rechtsrahmen sind die Plattformen verpflichtet, illegale Inhalte, wie z.B. Material über Kindesmissbrauch oder terroristische Inhalte, schnell zu entfernen, sobald sie von deren Existenz Kenntnis erlangt haben. Wir sind uns alle einig, dass der Zugang zu illegalen Inhalten verboten werden sollte. In einigen Fällen ist die Illegalität eines Inhalts jedoch sehr schwer zu beurteilen und erfordert eine angemessene rechtliche Bewertung. Ein Video kann beispielsweise entweder eine Verletzung des Urheberrechts darstellen oder es kann frei wieder hochgeladen werden, wenn es als Parodie verwendet wird.

Es kann eine Herausforderung sein, die Grenze zwischen illegal und legal zu ziehen. Der heikle Teil besteht darin, dass Online-Plattformen aufgrund des Umfangs der Verwaltung von Inhalten auf automatisierte Entscheidungshilfen als ultimative Lösung für diese sehr komplexe Aufgabe angewiesen sind. Um sich der Verantwortung zu entziehen, nutzen Plattformen die Automatisierung, um möglicherweise illegale Inhalte herauszufiltern. Aber wir können uns nicht ausschließlich auf diese Werkzeuge verlassen – wir brauchen Sicherheitsvorkehrungen und menschliches Eingreifen, um die Automatisierung zu kontrollieren.

Welche Sicherheitsvorkehrungen brauchen wir?

Ohne Zweifel ist die Moderation von Inhalten eine äußerst schwierige Aufgabe. Jeden Tag müssen Online-Plattformen harte Entscheidungen treffen und entscheiden, welche Inhalte online bleiben und wie wir sie finden. Der automatisierte Entscheidungsprozess wird die gesellschaftlichen Probleme wie Hassreden, Desinformation oder Terrorismus wahrscheinlich nie lösen. Während die Automatisierung bei Online-Inhalten, die unabhängig von ihrem Kontext offensichtlich illegal sind, wie z.B. Material über Kindesmissbrauch, gut funktionieren kann, versagt sie weiterhin in jedem Bereich, der nicht streng schwarz-weiß ist. Kein Werkzeug sollte das letzte Wort über den Schutz der Meinungsfreiheit oder des Privatlebens haben.

In der gegenwärtigen Situation bewerten und moderieren Online-Plattformen Inhalte, ohne uns zu sagen, wie und warum sie dies tun. Es besteht ein dringender Bedarf an Transparenz der Praktiken und Politiken dieser Online-Plattformen. Sie müssen Informationen darüber offenlegen, wie sie unsere Redefreiheit respektieren und welche Sorgfaltsmechanismen sie implementiert haben. Sie müssen transparent sein über ihren täglichen Betrieb, ihren Entscheidungsprozess und ihre Umsetzung sowie über ihre Folgenabschätzungen und andere politische Maßnahmen, die sich auf unsere grundlegenden Menschenrechte auswirken.

Neben der Transparenz brauchen wir auch angemessen ausgearbeitete Beschwerdemechanismen und menschliche Interventionen, wenn es einen automatisierten Entscheidungsprozess gibt. Ohne Menschen, ohne zugängliche und transparente Beschwerdemechanismen oder ohne Menschen, die für die Politik verantwortlich sind, kann es keine wirksame Abhilfe geben. Wenn die Möglichkeit besteht, dass Inhalte fälschlicherweise entfernt wurden, dann muss dies von einer echten Person überprüft werden, die entscheiden kann, ob der Inhalt legal war oder nicht. Wir sollten auch immer das Recht haben, die Angelegenheit vor einen Richter zu bringen, der rechtlich befugt ist, die endgültige Entscheidung in jeder Angelegenheit zu treffen, die unser Recht auf freie Meinungsäußerung beeinträchtigen könnte.

Weitere Informationen:

Wer sollte entscheiden, was wir online sehen? (20.02.2020)

Können wir uns darauf verlassen, dass Maschinen für uns Entscheidungen über illegale Inhalte treffen? (26.02.2020)

Ein menschenzentriertes Internet für Europa (19.02.2020)

Beitrag von Eliška Pírková, EDRi-Mitglied Access Now, und Eva Simon, Civil Liberties Union for Europe

Sicherheitsinformationsdienst gewinnt die tschechischen Big Brother Awards

Von Iuridicum Remedium

Die Gewinner des Czech Big Brother Award (BBA) 2019 sind der tschechische Sicherheitsinformationsdienst (BIS), das Antivirenunternehmen Avast und das Energieunternehmen PRE. Der positive Preis von Edward Snowden ging an die Stadt Prag.

Die Auszeichnungen wurden vom EDRi-Mitglied Iuridicum remedium (IuRe) während einer Pressekonferenz am 4. März 2020 überreicht. Es war die 15. jährliche Preisverleihung, und die Gewinner wurden von den neun Mitgliedern der Jury unter den öffentlichen Nominierungen ausgewählt.

Die BIS wurde über eine von ihr vorbereitete und genehmigte Gesetzesänderung ausgewählt. Gemäß der Gesetzesänderung können die Nachrichtendienste Datenbanken mit digitalen Fotos erstellen, die aus verschiedenen staatlichen Registern heruntergeladen werden, und diese zur Gesichtserkennung verwenden.

Die tschechische Firma Avast erhielt die BBA für den Verkauf der Daten ihrer Kunden. Die Jury wies auf das Problem der falschen Anonymisierung persönlicher Daten hin, die es ermöglichte, bestimmte Personen durch die Verbindung der verkauften Daten mit persönlichen Daten aus anderen Quellen neu zu identifizieren.

Der Energiekonzern PRE wurde für die langjährige Aufzeichnung von Kundengesprächen über seine Niederlassungen und für Verstöße gegen die Allgemeine Datenschutzverordnung (GDPR) und das Arbeitsgesetzbuch der EU durch die Überwachung von Mitarbeitern und falsche Informationen darüber ausgezeichnet.

Der Preis „Big Brother Statement“ wurde dem christdemokratischen (KDU-CSL) Abgeordneten Vit Kankovsky für die Erklärung verliehen, die mit der Präsentation der Gesetzgebung in der Abgeordnetenkammer verbunden war. Nach dieser Gesetzgebung wäre das tschechische Amt für den Schutz personenbezogener Daten nicht in der Lage, den öffentlichen Dienst und die lokalen Behörden wegen des GDPR zu bestrafen.

Der einzige positive „Edward-Snowden-Preis“ wurde der Stadt Prag für ihre Weigerung verliehen, die Gesichtserkennungstechnologie in das städtische Überwachungssystem in Prag einzuführen.

Die Big Brother Awards sind eine Veranstaltung, die die Verletzung unserer Privatsphäre hervorheben soll, insbesondere im Hinblick auf neue Überwachungsmethoden, die mit der Entwicklung der Technologie verbunden sind. Seit 1998 werden die Big Brother Awards in einer Reihe von Ländern in ganz Europa organisiert – in einigen Ländern sind die Awards eine neue Initiative, während in vielen anderen Ländern eine solide Tradition etabliert ist und die BBA zu einer jährlichen Veranstaltung geworden ist. Dank der BBA-Veranstaltungen werden die Informationen über die eklatantesten Verletzungen des Datenschutzes an die breite Öffentlichkeit weitergegeben.

Weitere Informationen:

Tschechische Big Brother Auszeichnungen

Tschechische Firmen Avast, PRE und BIS erhalten satirische Big Brother 2019 Auszeichnungen (04.03.2020)

Big Brother Auszeichnungen International

Beitrag des EDRi-Mitglieds Iuridicum Remedium – IuRE, Tschechische Republik

Wir begrüßen unsere neue leitende Politikberaterin Sarah Chander!

Von EDRi

European Digital Rights freut sich ganz besonders bekannt zu geben, dass Sarah Chander das Team im Brüsseler Büro als neue leitende Politikberaterin verstärkt hat. Sarah Chander wird als Senior Policy Adviser für EDRi arbeiten und sich unter anderem auf KI, Diskriminierung, Adtech und Hassreden konzentrieren. Darüber hinaus wird sie die Überschneidungen zwischen der Arbeit von EDRi und anderen sozialen Fragen untersuchen.

Sarah hat Erfahrung mit sozialen Bewegungen und zivilgesellschaftlichen Bemühungen und freut sich darauf, in den Bereich der digitalen Rechte einzusteigen. Zuvor arbeitete sie in der Anwaltschaft beim Europäischen Netzwerk gegen Rassismus (ENAR) an einer Vielzahl von Themen wie Antidiskriminierungsrecht und -politik, Hassverbrechen und Hassreden, rassistische Profilerstellung sowie Vielfalt und Integration. Davor arbeitete sie im Bereich Jugendbeschäftigungspolitik für den britischen öffentlichen Dienst. Sie war aktiv an Bewegungen gegen die Inhaftierung von Einwanderern beteiligt. Sie hat einen Master-Abschluss in Migration, Mobilität und Entwicklung von der SOAS, University of London, und einen Abschluss in Rechtswissenschaften von der University of Warwick.

Bei ENAR begann Sarah zu erforschen, wie sich der Bereich Antirassismus und digitale Rechte überschneiden, insbesondere wie Technik zunehmend von der Polizei und der Einwanderungskontrolle in ganz Europa und auch durch die KI im Bereich der Rekrutierung eingesetzt wird. Mehr darüber können Sie in ihrem Blogbeitrag über Datenrassismus lesen, den Sie hier auf Englisch finden und hier in Deutsch übersetzt.

Deutsche Übersetzung der englischsprachigen Originalbeiträge von EDRi von Lutz Martiny

0 Kommentare zu “EDRi-gram 18.5, 11. März 2020”