- Klicken Sie hier, um Benachrichtigungen beim grenzüberschreitenden Zugriff auf Daten zu ermöglichen

- Schwedische Strafverfolgungsbehörden erhalten die Erlaubnis zum Hacking

- Rumänien: Obligatorische SIM-Registrierung erneut für verfassungswidrig erklärt

- Dialoge mit Interessenvertretern des Urheberrechts: Kompromiss, Frustration, Sackgasse?

- EGMR: Datenspeicherung durch die britische Polizei verletzt das Recht auf Privatsphäre

- Einwanderung, Iris-Scanning und iBorderCTRL

- Können wir uns darauf verlassen, dass Maschinen für uns Entscheidungen über illegale Inhalte treffen?

Klicken Sie hier, um Benachrichtigungen beim grenzüberschreitenden Zugriff auf Daten zu ermöglichen

Von Chloé Berthélémy

Aus grundrechtlicher Sicht ist es von wesentlicher Bedeutung, dass der Vorschlag, der den grenzüberschreitenden Zugang zu Daten für Strafverfahren („e-Beweis“, „e-evidence“) ermöglicht, einen Benachrichtigungsmechanismus enthält. Dieses Erfordernis einer Benachrichtigung scheint jedoch für diejenigen, die sich für die „Effizienz“ grenzüberschreitender strafrechtlicher Ermittlungen einsetzen, nicht in Frage zu kommen, auch wenn dies die Aufgabe der grundlegendsten Verfahrensgarantien bedeutet, die es in der europäischen justiziellen Zusammenarbeit gibt. Ein weiteres Argument gegen die Notifizierung mindestens einer zweiten Behörde ist, dass das System „zu kompliziert“ wäre.

Um diese Kompliziertheit zu lösen, haben andere (mit ähnlichen Zielen) vorgeschlagen, den Anwendungsbereich des künftigen Rechtsinstruments auf „innerstaatliche“ Fälle zu beschränken. Dies bedeutet, dass die Produktions- und Aufbewahrungsvorschriften nur in Fällen verwendet werden würden, in denen die Person, deren Daten gesucht werden, im Land der ausstellenden Behörde ansässig ist. Wenn zum Beispiel eine französische Staatsanwaltschaft in einem Fall ermittelt, in dem eine in Frankreich ansässige Person als Verdächtiger auftritt, müsste sie nicht die Zustimmung eines anderen Staates einholen. Lediglich der Vollstreckungsstaat – in dem der Online-Dienstleister niedergelassen ist – müsste ausschließlich in den Fällen eingreifen, in denen der Anbieter die Ausführung der Verfügung verweigert.

„Innerstaatliche“ grenzüberschreitende Fälle?

Traditionell führen die EU-Mitgliedsstaaten ihre eigenen nationalen Gesetze aus, um die auf ihrem Territorium ansässigen Dienstleister vorzuladen, um die Daten ihrer Kunden in Strafsachen auszuhändigen. Wenn sich jedoch die gesuchten Beweise in einem anderen Mitgliedstaat befinden, kommen die Regeln der Europäischen Union für die justizielle Zusammenarbeit zum Tragen. Die neue Regelung, wie von der EU-Kommission vorgeschlagen, erlaubt es den Mitgliedstaaten, ihre gerichtliche Zuständigkeit über ihre territorialen Grenzen hinaus auszudehnen. Dies beeinträchtigt die Souveränität anderer Staaten – und deshalb sprechen wir vom grenzüberschreitenden Zugang zu Daten und können uns nicht auf „rein innerstaatliche Fälle“ beziehen.

Die Benachrichtigung einer zweiten Behörde, insbesondere der Vollstreckungsbehörde, ist unerlässlich, damit das neue Instrument mit dem Primärrecht (den EU-Verträgen) und dem Sekundärrecht der EU vereinbar ist. Für die Anwendung des Grundsatzes der gegenseitigen Anerkennung – der für den Vorschlag gewählten Rechtsgrundlage – ist es in der Tat von entscheidender Bedeutung, dass sich der Vollstreckungsstaat zunächst bewusst ist, dass eine Anordnung auf seinem Hoheitsgebiet vollstreckt wird, bevor er sie anerkennen kann.

Mitteilung an die Vollstreckungsbehörde

Einige Akteure in der E-Beweis-Debatte murren über den Verwaltungsaufwand, den ein Notifizierungsverfahren mit sich bringen würde. Sie betonen außerdem die problematische Situation, die es für die irischen Justizbehörden schaffen würde, da Irland so viele vorherrschende Dienstleister beherbergt. Es gibt jedoch mehrere Gegenargumente zu diesen Behauptungen:

- Der Vorschlag bezieht sich nicht nur auf die Umstände, unter denen Irland betroffen sein wird, sondern auf alle grenzüberschreitenden Fälle in der EU;

- Es ist von entscheidender Bedeutung, Verfahren zu entwerfen, die zukunftssicher sind. Der derzeitige Mangel an europäischer Harmonisierung im Bereich der Steuerpolitik beeinträchtigt die Effizienz der Instrumente der justiziellen Zusammenarbeit. Das bedeutet jedoch nicht, dass es immer so sein wird. Es ist auch keine zufriedenstellende Rechtfertigung für die Umgehung von Grundrechtsgarantien;

- Dienstleistungsanbieter sollten nicht verpflichtet werden, Aufträge auszuführen, die nach dem Recht des Landes, in dem sie ansässig sind, unrechtmäßig sind;

- In Fällen, in denen der Wohnsitz der betroffenen Person unbekannt ist, wäre ein Benachrichtigungsmechanismus für den Zugang zu identifizierenden Informationen unerlässlich, da es in diesem Stadium der Untersuchung keinen Hinweis darauf gibt, ob es einen betroffenen Drittstaat gibt oder nicht.

Es gibt Fälle, in denen die betroffene Person anderswo als im Anordnungsstaat ansässig ist. Der Ausschluss dieser Fälle aus dem Anwendungsbereich des E-Beweisvorschlags würde es den Strafverfolgungsbehörden ermöglichen, sich von einigen zusätzlichen rechtlichen Überprüfungen zu befreien – dies würde es ihnen insbesondere ermöglichen, die Überprüfung von Immunitäten oder anderen spezifischen Schutzmaßnahmen zu vermeiden, die durch nationale Gesetze gewährt werden und die den Zugang zu bestimmten Kategorien von personenbezogenen Daten einschränken. Dennoch würde der Ausschluss dieser Fälle nicht ausreichen, um der Verpflichtung zur Achtung der Grundrechte und der rechtsstaatlichen Standards, die im EU-Rechtssystem bei der Anwendung von Instrumenten der gegenseitigen Anerkennung vorgesehen sind, nachzukommen. Stattdessen sollte ein Benachrichtigungsmechanismus mit einer echten Überprüfungsmöglichkeit sowohl für den Vollstreckungsstaat als auch für die betroffenen Staaten in den endgültigen Text aufgenommen werden.

Weitere Informationen:

Doppelte Rechtmäßigkeitsprüfung bei E-Beweisen: Abschied von der „direkten Datenanfrage“ (12.02.2020)

„E-Beweise“: Das Unreparierbare reparieren (14.11.2019)

Unabhängige Studie enthüllt die Fallstricke von „E-Beweis“-Vorschlägen (10.10.2018)

EU-Vorschläge zum „E-Beweis“ machen Dienstleister zu Justizbehörden (17.04.2018)

Beitrag von Chloé Berthélémy, EDRi

Schwedische Strafverfolgungsbehörden erhalten die Erlaubnis zum Hacking

Von Dataskydd.net

Am 18. Februar 2020 verabschiedete das schwedische Parlament ein Gesetz, das es den schwedischen Strafverfolgungsbehörden ermöglicht, sich in Geräte wie Mobiltelefone und Computer zu hacken, von denen die Polizei annimmt, dass sie von einem Verdächtigen benutzt werden könnten. Wie bei dem kürzlich verabschiedeten neuen Gesetz zur Datenspeicherung stimmte nur eine Partei (und ein Mitglied einer anderen Partei) gegen die Resolution (286-26 bei 37 Abwesenheiten). Das bisherige Gesetz zur Vorratsdatenspeicherung wurde gestrichen, und angesichts der jüngsten Stellungnahmen des Generalanwalts (AG) des Gerichtshofs der Europäischen Union (CJEU) zur Vorratsdatenspeicherung dürfte auch das aktuelle Gesetz zur Vorratsdatenspeicherung gestrichen werden.

Welche Möglichkeiten bietet dies den Strafverfolgungsbehörden?

Für Verbrechen, die „unter den Umständen“ vernünftigerweise eine mindestens zweijährige Haftstrafe nach sich ziehen können, können die Strafverfolgungsbehörden (LEAs) einen Gerichtsbeschluss beantragen, um sich in das Gerät des Verdächtigen zu hacken. Dieser Durchsuchungsbefehl kann erteilt werden, um Informationen zu sammeln (z.B. aus verschlüsselten Nachrichtenanwendungen) oder in einigen Fällen sogar, um zu verhindern, dass Informationen von diesem Gerät gesendet werden.

Das Gesetz hat eine Reihe von ernsthaften Problemen, auf die der Gesetzgeber über mehrere Jahre hinweg hingewiesen wurde, als das Gesetz die Phase der öffentlichen Anhörung durchlief. Das Gesetz besagt beispielsweise nicht, dass eine Mindeststrafe von zwei Jahren Gefängnis erforderlich ist, sondern dass, wenn der Staatsanwalt nur glaubt, dass die vermutete Straftat zwei oder mehr Jahre Gefängnis nach sich ziehen könnte, die LEAs bereits die rechtliche Grundlage haben, um einen Durchsuchungsbeschluss zu beantragen.

Noch beunruhigender ist, dass sogar Bürger Ziel von Hacking durch die Polizei sein könnten, die nicht verdächtigt werden, ein Verbrechen begangen zu haben, aber mit einem Verdächtigen in Verbindung gebracht werden. Das Gesetz gibt den LEAs das Mandat, Geräte zu hacken, von denen sie vernünftigerweise annehmen, dass ein Verdächtiger sie hauptsächlich benutzen könnte. Wenn ein Verdächtiger zum Beispiel das Telefon seiner Mutter benutzt, kann dieses Gerät gehackt werden. Wenn Sie jemand sind, von dem die Polizei annimmt, dass der Verdächtige ihn anrufen oder ihm eine Nachricht zukommen lassen wird, könnte auch Ihr Telefon in Gefahr sein, gehackt zu werden, nur weil Sie zufällig jemanden kennen, den die Polizei eines Verbrechens verdächtigt. Es kann den Behörden auch erlaubt werden, Hacking zu verwenden, um einen Verdächtigen zu finden – das bedeutet, dass Sie einfach nicht zur falschen Zeit am falschen Ort sein sollten, sonst könnte die Polizei Ihre Geräte hacken.

Das Gesetz enthält auch eine Klausel, die besagt, dass der Staatsanwalt einen Durchsuchungsbefehl ausstellen kann, wenn er das Gefühl hat, dass die Gerichte zu langsam sind. Wenn das Gericht dann feststellt, dass der Haftbefehl zu Unrecht ausgestellt wurde, muss der Staatsanwalt dann zur Überprüfung vor Gericht gehen, und alle gesammelten Beweise können nicht gegen den Verdächtigen verwendet werden. Natürlich ist die Person, deren Gerät gehackt wurde (die vielleicht nicht einmal eine Person ist, die eines Verbrechens verdächtigt wird), bereits in ihre Privatsphäre verletzt worden, und das Gesetz sieht für solche Missbräuche keinen Rechtsbehelf vor.

Das neue Gesetz tritt am 1. April 2020 in Kraft und wird fünf Jahre lang gültig sein, danach wird das schwedische Parlament beschließen, es dauerhaft zu machen oder nicht.

Weitere Informationen:

Stellungnahme der AG: Massenaufbewahrung von Daten, die nicht mit dem EU-Recht vereinbar sind (29.01.2020)

Vorschlag für das Gesetz zum Hacking durch die Polizei 2019/20:64 (nur auf Schwedisch)

Erklärung von Dataskydd.net zum Bericht, der das neue Gesetz vorschlägt (PDF, nur auf Schwedisch)

Beitrag von Eric Skoglund, EDRi-Beobachter Dataskydd.net

Rumänien: Obligatorische SIM-Registrierung erneut für verfassungswidrig erklärt

Von ApTI

Am 18. Februar 2020 erklärte das rumänische Verfassungsgericht einstimmig ein neues Gesetz, das im September 2019 verabschiedet wurde und die obligatorische Registrierung von SIM-Karten einführt, für verfassungswidrig. Bei dem fraglichen Rechtsakt handelte es sich um eine von der Regierung erlassene Notverordnung, die diese Verpflichtung als Maßnahme zur „Verbesserung der Funktionsweise der Notrufnummer 112“ einführen wollte. Dies ist das zweite Mal, dass das Gericht eine Verfassungswidrigkeitsentscheidung über Vorschläge zur obligatorischen Registrierung von SIM-Karten erlässt.

Das Gericht wies das Gesetz aus verfahrenstechnischen Gründen ab, da die Regierung die Dringlichkeit der Verabschiedung der Verordnung nicht nachgewiesen hat. In seiner Pressemitteilung hob es auch hervor, dass dieser Akt der Einführung der SIM-Karten-Registrierungsbestimmung tatsächlich zweimal verschoben wurde, so dass die Dringlichkeit der Verabschiedung einer Dringlichkeitsverordnung nicht gegeben war.

Obwohl dies der sechste Versuch ist, eine Gesetzgebung zur obligatorischen SIM-Karten-Registrierung in Rumänien einzuführen, ist der Kampf noch lange nicht beendet, da das Gericht diesmal nicht auf eine inhaltliche Analyse eingegangen ist.

Zufällig oder nicht, zwei Tage später wurde in den Medien über eine falsche Bombendrohung (die erste seit Jahren) berichtet. Ein Mann rief die Notrufnummer 112 an und behauptete, er habe eine Bombe in einem Einkaufszentrum platziert. Der Anruf wurde von einer Prepaid-SIM-Karte getätigt, eine Tatsache, die der 112-Dienst in seiner Pressemitteilung besonders hervorhob, während er die Zahl der Mitarbeiter, die an der Beantwortung dieses Anrufs beteiligt waren, erhöhte, was subtil darauf hindeutet, dass die Auswirkungen dieser Art von Anrufen massiv sind, und wenn sie sich als falsch herausstellen, gibt es niemanden, der dafür verantwortlich gemacht werden kann, da Prepaid-SIM-Karten-Anrufe nicht zu einer Person zurückverfolgt werden können.

Die Entscheidung des Verfassungsgerichts ist vorerst ein willkommener Sieg, aber angesichts der Erfolgsgeschichte, die sich aus der Vorlage eines neuen Gesetzesvorschlags zu diesem Thema alle ein oder zwei Jahre ergibt, können wir in Zukunft ähnliche Gesetzesvorschläge erwarten.

Hintergrund

Nach dem tragischen Scheitern der Polizei bei der Rettung eines Teenagers, der entführt wurde, es aber schaffte, die Notrufnummer 112 drei Mal anzurufen, bevor er ermordet wurde, verabschiedete die rumänische Regierung eine Notverordnung, die die Verpflichtung zur Registrierung von Prepaid-SIM-Karten einführte.

Das EDRi-Mitglied ApTI forderte gemeinsam mit der Vereinigung zur Verteidigung der Menschenrechte in Rumänien – dem Helsinki-Komitee (APADOR-CH) – den rumänischen Ombudsmann auf, das Gesetz an das Verfassungsgericht zu schicken. Der Bürgerbeauftragte focht den Fall vor Gericht an, und ApTI schickte einen Amicus Curiae (Ein Amicus Curiae Brief (dt. Freund des Gerichts) ist ein Schriftsatz an ein Gericht, in dem eine am Verfahren nicht selbst beteiligte Person oder Organisation rechtliche Argumente und eine Handlungsempfehlung für einen vor Gericht ausgetragenen Fall darlegen kann.) zur Unterstützung der Verfassungswidrigkeitsansprüche, um dies zu zeigen:

- es keinen Grund gab, die Annahme einer Dringlichkeitsverordnung zu rechtfertigen, anstatt das normale parlamentarische Verfahren zu durchlaufen;

- die Beschränkung der individuellen Freiheiten durch die Forderung nach der Registrierung von Prepaid-SIM-Karten eine Maßnahme ist, die in keinem Verhältnis zu dem angestrebten Ziel steht – die Beschränkung gefälschter Anrufe auf die 112-Notrufnummer;

- es wurde keine Datenschutzfolgenabschätzung durchgeführt, und die nationale Datenschutzbehörde hat das Gesetz nicht unterstützt;

- das Verfassungsgericht hat bereits 2014 entschieden, dass die Maßnahme zur Einführung der obligatorischen Registrierung von SIM-Karten die Grundrechte und -freiheiten einschränkt und solche Maßnahmen nur eingeführt werden können, wenn sie notwendig und verhältnismäßig sind.

Weitere Informationen:

Der 6. Versuch zur Einführung der obligatorischen Registrierung von SIM-Karten in Rumänien (23.10.2020)

Pressemitteilung des Verfassungsgerichts (PDF, nur auf Rumänisch, 18.02.2020)

Zeitleiste der Gesetzesinitiativen zur Einführung der obligatorischen Registrierung von SIM-Karten (nur auf Rumänisch)

Gefälschte Bombendrohung in einem Einkaufszentrum in Rumänien (nur auf Rumänisch, 20.02.2020)

Entscheidung des Verfassungsgerichts Nr. 461/2014 (nur auf Rumänisch)

Beitrag von Valentina Pavel, EDRi-Mitglied ApTI, Rumänien

Dialoge mit Interessenvertretern des Urheberrechts: Kompromiss, Frustration, Sackgasse?

Von Laureline Lemoine

Die zweite Phase der Stakeholder-Dialoge zu Artikel 17 der Urheberrechtsrichtlinie wurde im Dezember 2019 abgeschlossen. Die beiden Treffen der dritten Phase, die sich auf die Bestimmungen von Artikel 17 konzentrierten, fanden am 16. Januar und 10. Februar 2020 statt.

Die Konzepte der Genehmigung und der besten Bemühungen wurden in der ersten Sitzung am 16. Januar diskutiert. Die zweite Sitzung am 10. Februar befasste sich mit den Schutz- und Rechtsschutzmechanismen für die Nutzer.

Können wir Artikel 17 noch korrigieren?

Am 10. Februar bot der Dialog zum ersten Mal die Gelegenheit, die zentrale Frage von Artikel 17 (früherer Artikel 13) zu erörtern: den Konflikt zwischen den Verpflichtungen der Plattformen und den Rechten der Nutzer.

Artikel 17 Absatz 4 verlangt von den Plattformen, sich nach besten Kräften zu bemühen, die Verfügbarkeit urheberrechtlich geschützter Inhalte zu vermeiden, was in der Praxis die Implementierung von Upload-Filtern erzwingt. Auf der anderen Seite stellt Artikel 17 Absatz 7 sicher, dass die Zusammenarbeit zwischen Rechteinhabern und Plattformen nicht zur Blockierung oder Entfernung legitimer Inhalte, wie z.B. urheberrechtliche Ausnahmen, führt. Es hat sich gezeigt, dass die Filter selbst während dieser Dialoge den Kontext nicht verstehen und daher nicht erkennen können, wenn Nutzer von urheberrechtlichen Ausnahmen wie Kritik oder Parodie Gebrauch machen. Die Interessenvertreter diskutierten, wie dieser Konflikt gelöst werden könnte.

Nutzerorganisationen stellten konkrete Szenarien vor, um die automatische Blockierung von Inhalten zu vermeiden

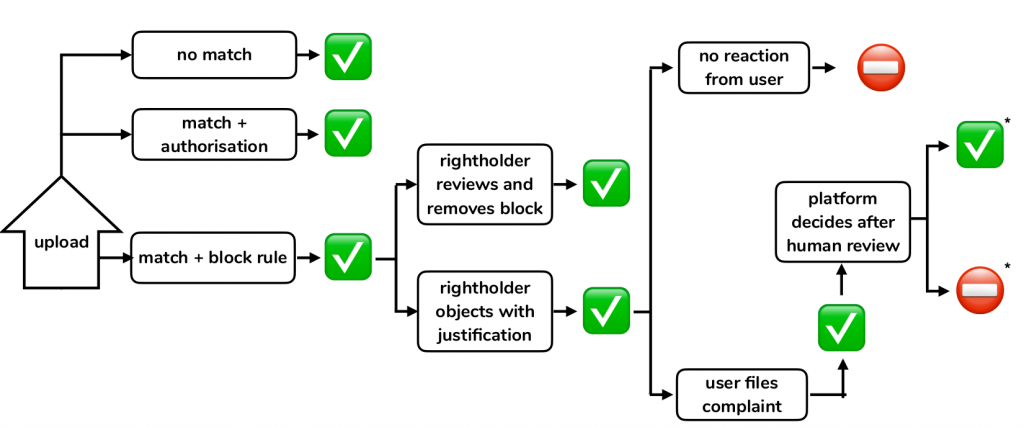

Wie könnte dieser Konflikt in der Praxis gelöst werden? EDRi unterstützt ein Szenario, bei dem die von Filtern markierten Inhalte während des gesamten Überprüfungsprozesses online bleiben würden, vom Zeitpunkt des Hochladens bis zur menschlichen Überprüfung, wie im Bild unten zu sehen ist.

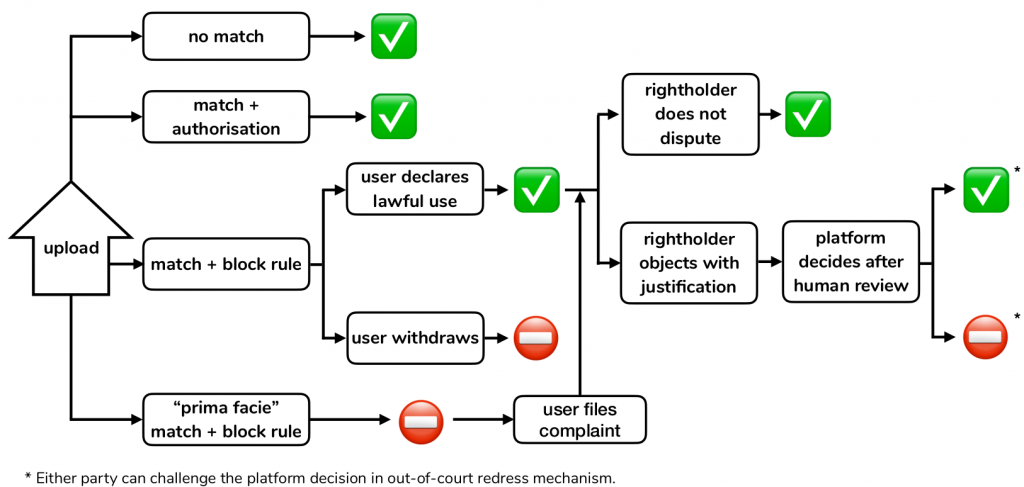

Communia, eine NGO, die eine Politik fördert, die den öffentlichen Bereich auf eine breitere Basis stellt, präsentierte ein etwas anderes Szenario, das auf Empfehlungen von Wissenschaftlern beruht. Sie unterscheiden zwischen zwei Arten von Urheberrechtsverletzungen, die durch Filter gekennzeichnet sind:

- Erstens eine „prima facie“ (dem ersten Anschein nach) Urheberrechtsverletzung, d.h. eine identische oder gleichwertige Übereinstimmung mit einem geschützten Inhalt, die zu einer automatischen Sperrung des Inhalts führen würde. Die Nutzer hätten jedoch weiterhin die Möglichkeit, sich zu beschweren und die Schutzvorkehrungen von Artikel 17 Absatz 9 in Anspruch zu nehmen. Wegen des Missbrauchspotentials sieht der Vorschlag auch mögliche Sanktionen für Rechteinhaber vor, die wiederholt unberechtigte Eigentumsansprüche geltend machen.

- Zweitens könnten die Nutzer in Fällen teilweiser Übereinstimmung mit geschützten Inhalten Erklärungen über die rechtmäßige Nutzung abgeben, so dass ihre Inhalte während des gesamten Prozesses bis zur menschlichen Überprüfung aufrechterhalten werden könnten.

Die Europäische Verbraucherorganisation BEUC schlug außerdem vor, dass die Nutzer über das Urheberrecht aufgeklärt werden sollten, damit sie diese Erklärung in vollem Umfang nutzen können.

Überraschenderweise stellte Studio 71, ein globales Medienunternehmen im Besitz von Rundfunkanstalten, ein ähnliches Modell vor, das auf demselben akademischen Papier basiert. Der Unterschied zum Communia-Szenario besteht in der Einführung eines „roten Knopfs“, mit dem die Rechteinhaber Inhalte sofort blockieren können, selbst wenn ein Benutzer eine Erklärung über die rechtmäßige Nutzung abgibt. Der Vorschlag von Studio 71 sieht auch Sanktionen für Benutzer und Rechteinhaber im Falle eines wiederholten Missbrauchs vor. Sie legten sogar Beweise für ihre eigene Überblockierung vor, indem sie sagten, dass sie angeblich einmal zu Unrecht 50.000 Inhalte blockiert haben.

Die Europäische Kommission zeigte Interesse und forderte immer wieder weitere Einzelheiten, insbesondere hinsichtlich der konkreten Umsetzung einer Prima-Facie-Regel. Es wurde jedoch schnell klar, dass die meisten Rechteinhaber kein Interesse an einer solchen Diskussion hatten und stattdessen darauf bestanden, dass ihre Rechte Vorrang haben sollten und dass der Beschwerde- und Abhilfemechanismus die einzige Lösung für eine Überblockierung sei.

Es ist nicht das erste Mal, dass sich die Interessengruppen weigern, sich sinnvoll in den Dialogprozess einzubringen. Am 16. Januar weigerten sich die meisten von ihnen, einen nützlichen Beitrag zur Definition wichtiger Konzepte von Artikel 17 zu leisten. Die Rechteinhaber haben kein Interesse an Richtlinien gezeigt, die ihre Blockierungsmöglichkeiten einschränken würden, und große Plattformen verwalten bereits ihre eigenen Blockierungsinstrumente.

Europäische Kommission zur Rettung?

Angesichts der Haltung der Rechteinhaber erklärte die Europäische Kommission, dass ihre Rolle in diesem Dialog darin bestehe, die Wirksamkeit der Ausnahmen sicherzustellen. Sie sind der Meinung, dass die Auslegung von Artikel 17, bei der der einzige Rechtsbehelf, der den Nutzern zur Verfügung steht, der Rechtsbehelfsmechanismus ist, eine solche Wirksamkeit möglicherweise nicht gewährleistet. Sie zitierten die Rechtsprechung des Gerichtshofs und sagten, dass Ausnahmen für die Meinungsfreiheit besonders wichtig seien. Sie ermutigten die Rechteinhaber dann nachdrücklich, praktikable konkrete Lösungen vorzuschlagen, anstatt jeden Kompromissversuch zu unterbinden.

Trotz des Eingreifens der Kommission tappt man jedoch immer noch im Dunkeln, was den Inhalt der Richtlinien betrifft und ob sie tatsächlich in der Lage sein werden, die Rechte der Nutzer gegen mächtige kommerzielle Interessen zu schützen. Werden sich die EU-Mitgliedstaaten bei der Umsetzung der Richtlinie an die Leitlinien halten? Einige Mitgliedstaaten haben bereits ihre Umsetzungsgesetze ausgearbeitet, und es fehlt der Schutz der Nutzerrechte. Die Kommission muss aktiv sicherstellen, dass die nationalen Umsetzungen der Richtlinie die Nutzerrechte wirksam schützen.

Wie geht es weiter?

Die Europäische Kommission sagte, sie werde über die während dieser sechs Treffen mit den Interessenvertretern erhaltenen Beiträge nachdenken, will sich aber um den 30. März herum erneut treffen. Dieses letzte Treffen würde die Gelegenheit bieten, erste Meinungen zum Inhalt der Richtlinien zu präsentieren. Die Kommission wird auch eine schriftliche und gezielte Konsultation der Interessenvertreter einleiten, deren Einzelheiten auf der Sitzung im März bekannt gegeben werden sollen.

Wir hoffen, dass dies bedeutet, dass uns der gesamte Richtlinienentwurf mitgeteilt wird und dass der Zweck dieser Konsultation darin besteht, Rückmeldungen darüber einzuholen, ob das Dokument weiter verbessert werden kann, um die Einhaltung der Charta der Grundrechte der EU zu gewährleisten, wie wir im Januar 2020 gefordert haben.

Weitere Informationen:

Artikel 17 Stakeholder-Dialog (Tag 6): Vor die Wand laufen

Dialoge mit Interessenvertretern des Urheberrechts: Filter können keinen Kontext verstehen

EU-Urheberrechtsdialoge: Das nächste Schlachtfeld zur Verhinderung von Upload-Filtern (18.10.2019)

NGOs fordern die Gewährleistung der Grundrechte bei der Umsetzung des Urheberrechts (20.05.2019)

Urheberrecht: Offener Brief mit der Forderung nach Transparenz bei der Umsetzung von Richtlinien (15.01.2020)

Beitrag von Laureline Lemoine, EDRi

EGMR: Datenspeicherung durch die britische Polizei verletzt das Recht auf Privatsphäre

Von Laureline Lemoine

Am 13. Februar 2020 erließ der Europäische Gerichtshof für Menschenrechte (EGMR) sein Urteil in der Rechtssache Gaughran gegen das Vereinigte Königreich (UK) über die unbefristete Aufbewahrung von personenbezogenen Daten (DNA-Profil, Fingerabdrücke und Foto) eines Mannes, der eine Verurteilung verbüßt hat. Das Gericht entschied, dass im Fall des Antragstellers die fragliche Vorratsspeicherung einen unverhältnismäßigen Eingriff und damit eine Verletzung seines Rechts auf Achtung des Privatlebens (Art. 8 der Europäischen Menschenrechtskonvention) darstellt, da der Eingriff in einer demokratischen Gesellschaft nicht als notwendig angesehen werden kann.

Das Gericht stützte sich in einem Großteil seiner Argumente auf den Fall S. und Marper gegen das Vereinigte Königreich (2008), in dem es feststellte, dass die pauschale und unterschiedslose Art der Befugnisse zur Aufbewahrung der Fingerabdrücke, Zellproben und DNA-Profile der Antragsteller, die im Vereinigten Königreich verdächtigt, aber nicht verurteilt wurden, gegen ihr Recht auf Achtung des Privatlebens verstieß. In der Folge wurden die einschlägigen Rechtsvorschriften in England und Wales geändert, nicht jedoch in Nordirland, wo der Antragsteller im Fall Gaughran die Straftat beging, für die er verurteilt wurde.

Unbefristete Aufbewahrungsregelung und fehlende notwendige und relevante Schutzmaßnahmen

Nach der Rechtsprechung des EGMR konzentriert sich der Gerichtshof bei der Beurteilung der Verhältnismäßigkeit einer Maßnahme nicht unbedingt oder ausschließlich auf die Dauer der Aufbewahrungsfrist. Der Gerichtshof wird vielmehr prüfen, ob die Regelung die Schwere der Straftat und die Notwendigkeit der Vorratsspeicherung der Daten sowie die dem Einzelnen zur Verfügung stehenden Schutzmaßnahmen berücksichtigt.

Da sich das Vereinigte Königreich in diesem Fall für die Einführung einer Regelung zur unbegrenzten Vorratsspeicherung entschieden hat, argumentiert das Gericht, dass „der Staat daher sicherstellen muss, dass bestimmte Garantien vorhanden und für den Antragsteller wirksam sind“ (Rn. 94).

Das Gericht wies in diesem Zusammenhang auf das Fehlen jeglicher relevanter Schutzvorkehrungen hin. Erstens wurden die biometrischen Daten und das Foto des Antragstellers „ohne Hinweis auf die Schwere seiner Straftat und ohne Rücksicht auf die Notwendigkeit, diese Daten auf unbestimmte Zeit zu speichern“, aufbewahrt. Darüber hinaus stellte das Gericht fest, dass es kein wirkliches Verfahren zur Überprüfung gibt, die der Person und der Polizei, die die Daten nur in Ausnahmefällen löschen kann, zur Verfügung steht (Rn. 94).

Das Vereinigte Königreich überschritt den akzeptablen Ermessensspielraum

Bei der Bewertung der Verhältnismäßigkeit wird auch der Spielraum für die Bewertung des Staates berücksichtigt. Ähnlich wie beim Argument der nationalen Sicherheit wird ein großer Ermessensspielraum oft von den Regierungen zur Rechtfertigung von Maßnahmen, die in die Grundrechte eingreifen, geltend gemacht.

Das Gericht befand, dass der Spielraum viel enger ist als das, was das Vereinigte Königreich behauptete, und immer noch nicht weit genug, um zu dem Schluss zu kommen, dass die Beibehaltung verhältnismäßig ist. Im Gegensatz zu den Aussagen des Vereinigten Königreichs stellt der Gerichtshof fest (Paragraph 82-84), dass es in den meisten Staaten Regime gibt, in denen es eine definierte Aufbewahrungsfrist gibt. Darüber hinaus stellt er fest, dass das Vereinigte Königreich eine der wenigen Gerichtsbarkeiten des Europarates ist, die eine unbegrenzte Aufbewahrung von DNA-Profilen, Fingerabdrücken und Fotos von verurteilten Personen erlaubt.

Darüber hinaus behauptete das Vereinigte Königreich, dass Maßnahmen zur unbegrenzten Aufbewahrung relevant und ausreichend seien, da je mehr Daten aufbewahrt werden, desto mehr Verbrechen verhindert werden. Diese gefährliche und falsche Erzählung wurde vom Gericht angefochten, da dies „die Speicherung von Informationen über die gesamte Bevölkerung und ihre verstorbenen Verwandten rechtfertigen würde, was mit Sicherheit übertrieben und irrelevant wäre“ (Paragraph 89).

Vorsicht vor sich entwickelnden Technologien

Eines der Argumente des Vereinigten Königreichs bezüglich der Verhältnismäßigkeit der Maßnahme war, dass das Foto des Antragstellers in einer lokalen Datenbank gespeichert war und nicht mit anderen Fotos abgeglichen werden konnte. Die Technologie habe sich jedoch seitdem weiterentwickelt, und die Polizei sei nun in der Lage, Gesichtserkennungs- und -kartierungstechniken auf das Foto des Antragstellers anzuwenden, indem sie es in eine nationale Datenbank hochlädt.

Die mögliche Anwendung der Gesichtserkennung war ausschlaggebend dafür, ob das Recht auf Privatsphäre verletzt wurde. Das Gericht wies auch auf das Risiko solcher sich entwickelnder Technologien in Bezug auf die Staatsgewalt hin. In diesem Zusammenhang betont das Gericht die Notwendigkeit, die Einhaltung des Rechts auf Privatsphäre zu prüfen, wenn einem Staat „obskure Befugnisse“ übertragen werden, „wodurch die Gefahr der Willkür entsteht, insbesondere dann, wenn die verfügbare Technologie ständig weiterentwickelt wird“ (Paragraph 88).

Da die persönlichen Daten des Antragstellers ohne Berücksichtigung der Schwere seines Vergehens, der Notwendigkeit einer unbegrenzten Aufbewahrung und ohne wirkliche Überprüfungsmöglichkeit auf unbestimmte Zeit aufbewahrt wurden, stellte das Gericht einstimmig fest, dass ein Verstoß gegen Artikel 8 (Recht auf Achtung des Privat- und Familienlebens) der Europäischen Menschenrechtskonvention vorlag.

Dieses Urteil ist besonders relevant, weil es zeigt, dass eine pauschale Datenspeicherungspolitik ohne jegliche Schutzvorkehrungen das Recht des Einzelnen auf Privatsphäre verletzt, selbst wenn Maßnahmen als in das Ermessen des Staates fallend betrachtet werden. Dieses Urteil könnte sich auch auf die laufenden Diskussionen in der EU über künftige Rechtsvorschriften zur Vorratsdatenspeicherung sowie auf laufende Verfahren vor dem Gerichtshof der EU auswirken.

Weitere Informationen:

Urteil – Fall Gaughran gegen das Vereinigte Königreich

Pressemitteilung: Unbestimmte Aufbewahrung von DNA, Fingerabdrücken und Foto eines wegen Trunkenheit am Steuer verurteilten Mannes verletzte seine Persönlichkeitsrechte (13.02.2020)

Datenspeicherung: „Nationale Sicherheit“ ist kein Blankoscheck (29.01.2020)

Erneut unterschiedslose Datenspeicherung als unverhältnismäßig angesehen (15.01.2020)

Beitrag von Laureline Lemoine, EDRi), EDRi

Einwanderung, Iris-Scanning und iBorderCTRL

Von Petra Molnar

Technologien wie automatisierte Entscheidungsfindung, Biometrie und unbemannte Drohnen kontrollieren zunehmend die Migration und betreffen Millionen von Menschen, die sich in Bewegung befinden. Dieser zweite Blog-Beitrag in unserer Serie über KI und Migration beleuchtet einige dieser Anwendungen, um die sehr realen Auswirkungen auf das Leben der Menschen zu zeigen, die durch einen Mangel an sinnvollen Steuerungs- und Kontrollmechanismen dieser technologischen Experimente noch verschärft werden.

Was kann Ihnen auf Ihrer Migrationsreise passieren, wenn Bots involviert sind?

Vor der Grenze: Wollen Sie essen? Lassen Sie Ihre Augen scannen!

Noch bevor Sie eine Grenze überschreiten, werden Sie mit verschiedenen Technologien interagieren. Unter dem Deckmantel der Grenzkontrolle überwachen unbemannte Drohnen den Mittelmeerkorridor. Wenn jedoch ähnliche Technologien, wie die so genannte „intelligente Grenzüberwachung“ an den US-Grenzen, ein Hinweis darauf sind, kann dies dazu führen, dass mehr Menschen auf der Suche nach Sicherheit sterben. Biometrische Verfahren wie das Scannen der Iris werden zunehmend in humanitären Einrichtungen eingesetzt – wo Flüchtlinge zusätzlich zu ihren ohnehin schwierigen Lebensbedingungen ihre Augen scannen lassen müssen, um beispielsweise zu Essen zu bekommen. Und jetzt sind nicht einmal die persönlichen Posts, die Sie nur mit Ihren Freunden und Familienmitgliedern teilen wollten, sicher – das Scannen von Einwanderungsanträgen in den sozialen Medien wird zur gängigen Praxis.

Was geschieht mit all diesen Daten? Verschiedene internationale Organisationen wie die Vereinten Nationen (UN) verwenden große Datenmengen oder extrem große Datensätze, um Bevölkerungsbewegungen vorherzusagen. Die Datenerfassung ist jedoch keine unpolitische Übung, insbesondere wenn mächtige Akteure wie Staaten oder internationale Organisationen wie die UNO Informationen über gefährdete Bevölkerungsgruppen sammeln. In einer zunehmend einwanderungsfeindlichen globalen Landschaft werden Migrationsdaten auch für politische Zwecke falsch dargestellt, um die Verteilung von Hilfsgeldern und Ressourcen zu beeinflussen und eine harte Anti-Einwanderungspolitik zu unterstützen.

Besorgniserregend ist auch die wachsende Rolle des privaten Sektors bei der Sammlung, Nutzung und Speicherung dieser Daten. Das Welternährungsprogramm unterzeichnete kürzlich einen Vertrag über 45 Millionen USD mit Palantir Technologies, die vor kurzem dem EU-Lobby-Register beigetreten sind, demselben Unternehmen, das weithin dafür kritisiert wurde, dass es Technologien zur Unterstützung der von der US-Einwanderungs- und Zollbehörde ICE (Immigration and Customs Enforcement) durchgeführten Programme zur Inhaftierung und Abschiebung bereitstellt. Was wird mit den Daten von 92 Millionen Hilfsempfängern geschehen, die mit Palantir geteilt werden? Welche Mechanismen der Datenverantwortung gibt es während dieser Partnerschaft, und können die Betroffenen die gemeinsame Nutzung ihrer Daten verweigern?

An der Grenze: Lügen Sie? Ein Bot kann das erkennen!

Wenn Sie an der Grenze ankommen, scheinen mehr und mehr Maschinen zu erscheinen, die Sie scannen, überwachen und Informationen über sie sammeln. Diese Maschinen sind in zunehmendem Maße auf automatisierte Entscheidungsfindung angewiesen. Allerdings sind Fälle von Verzerrungen bei der automatischen Entscheidungsfindung weitgehend dokumentiert. Es sind Pilotprojekte entstanden, um Ihr Gesicht auf Anzeichen von Lügen zu überwachen, und wenn das System durch eine Reihe von immer komplizierteren Fragen „skeptischer“ wird, werden Sie für eine weitere Überprüfung durch einen menschlichen Beamten ausgewählt. Kann dieses System jedoch die interkulturellen Unterschiede, in denen wir kommunizieren, berücksichtigen? Was ist, wenn Sie traumatisiert sind und sich nicht mehr klar an Einzelheiten erinnern können? Die diskriminierende Anwendung von Gesichts- oder Emotionserkennungstechnologien hat weitreichende Folgen für das Leben und die Rechte der Menschen, insbesondere im Bereich der Migration.

Über die Grenze hinaus: Automatisierung von Entscheidungen

Wenn Sie ein Visum beantragen oder Ihren Ehepartner es ermöglichne wollen, zu Ihnen zu kommen, was halten Sie von Algorithmen, die über Ihre Anträge entscheiden? Eine Vielzahl von Ländern hat damit begonnen, mit der Automatisierung von Entscheidungen bei Einwanderungs- und Flüchtlingsanträgen, Visa und sogar der Einwanderungshaft zu experimentieren. Dieser Einsatz von Technologie mag wie eine gute Idee erscheinen, aber viele Einwanderungsanträge sind kompliziert. Schon zwei menschliche Beamte, die sich die gleichen Beweise ansehen, können zwei völlig unterschiedliche Entscheidungen treffen. Wie wird ein automatisiertes System mit den Nuancen umgehen können? Oder was, wenn Sie eine Entscheidung, mit der Sie nicht einverstanden sind, vor Gericht anfechten wollen? Im Moment ist unklar, wer dafür verantwortlich ist, wenn etwas schief läuft – ist es der Codierer, der den Algorithmus programmiert, der Einwanderungsbeamte, der ihn verwendet, oder sogar der Algorithmus selbst?

Fehler bei Migrationsentscheidungen können dauerhafte Auswirkungen haben – Sie können von Ihrer Familie getrennt werden, Ihren Job verlieren oder sogar zu Unrecht abgeschoben werden. Dies geschah bei über 7000 Studenten, die aufgrund eines fehlerhaften Algorithmus, der sie des Betrugs bei einem Sprachtest beschuldigte, aus dem Vereinigten Königreich abgeschoben wurden. Wo sind diese Studenten jetzt?

Was ist mit Ihren Menschenrechten?

Eine Reihe Ihrer international geschützten Rechte sind bereits mit dem immer weiter verbreiteten Einsatz neuer Technologien zur Steuerung der Migration beschäftigt. Dazu gehören Gleichheitsrechte und Freiheit von Diskriminierung, Leben, Freiheit und Sicherheit der Person, Meinungsfreiheit und Rechte auf Privatsphäre. Wenn öffentliche Einrichtungen Entscheidungen über Sie treffen, sind auch Ihre Rechte auf ein ordnungsgemäßes Verfahren betroffen, einschließlich des Rechts auf einen unparteiischen Entscheidungsträger, des Rechts auf Berufung und des Rechts, über den Fall gegen Sie Bescheid zu wissen. Diese Rechte sind besonders wichtig, wenn es um ein hohes Risiko geht, wie z.B. bei der Entscheidung über Ihre Arbeitslosenunterstützung, ob Sie für ein Vorstellungsgespräch ausgewählt werden oder nicht, wenn die Auswirkungen falscher Entscheidungen Familien trennen, die Karriere ruinieren oder in extremen Fällen Ihr Leben und Ihre Freiheit beeinträchtigen können.

Derzeit gibt es jedoch keinen integrierten regulatorischen Global-Governance-Rahmen für den Einsatz von automatisierten Technologien und keine spezifischen Vorschriften im Zusammenhang mit der Migrationssteuerung. Ein Großteil der globalen Gespräche dreht sich um Ethik ohne klare Durchsetzungsmechanismen und sinnvolle Rechenschaftspflicht. Die Unterzeichnung und Ratifizierung der Konvention 108+ sollte für Staaten auf der ganzen Welt eine Priorität sein, ebenso wie die konsequente Durchsetzung des darin vorgesehenen Schutzes.

Unser nächster Blog-Beitrag wird einige dieser Rechte untersuchen und einen Weg zu kontextspezifischen Rechenschafts- und Steuerungsmechanismen für Migrationskontrolltechnologien vorschlagen.

Weitere Informationen:

Beitrag, Petra Molnar, Mozilla-Stipendiatin, EDRi

Können wir uns darauf verlassen, dass Maschinen für uns Entscheidungen über illegale Inhalte treffen?

Von Access Now

Während die Automatisierung für die Handhabung einer großen Menge von Inhalten, die von den Benutzern gemeinsam genutzt werden, notwendig ist, macht sie Fehler, die für Ihre Rechte und das Wohlergehen der Gesellschaft weitreichend sein können.

Die meisten von uns diskutieren gerne ihre Ideen und Meinungen zu dummen und ernsten Themen, teilen glückliche und traurige Momente und spielen gemeinsam im Internet. Und das ist eine großartige Sache. Wir alle wollen die Freiheit haben, neue Dinge zu lernen, mit unseren Freunden in Kontakt zu treten und neue Menschen zu erreichen. Jede Minute werden Fotos, Videos und Ideen ausgetauscht. Jede einzelne Minute werden 527 760 Fotos auf Snapchat, 4 146 600 Videos auf YouTube, 456 000 Tweets und etwa 46 740 Fotos auf Instagram veröffentlicht. Wissen Sie, wie viele Minuten wir an einem Tag haben? 1440.

Diese Informationen sind unterschiedlicher Natur. Einige von ihnen sind Heimvideos, und das Gesetz hat nichts damit zu tun. Aber es gibt Inhalte, die eindeutig gegen das Gesetz verstoßen, wie z.B. Material über Kindesmissbrauch oder die Anstiftung zu Gewalt. Und zwischen legalen und illegalen Inhalten gibt es eine dritte Gruppe, die manche Menschen als schädlich empfinden, während andere damit kein Problem haben. Zwar nicht illegal, aber einige Eltern möchten verhindern, dass ihre Kinder im Alter von 12 Jahren Zugang zu Pornographie erhalten. Es ist nicht leicht zu definieren und ganz zu schweigen davon, was schädlich ist und für wen. Es hängt von der Kultur, dem Alter, den Umständen und so vielen anderen Faktoren ab.

Da eine große Menge von Internet-Inhalten auf Online-Plattformen gehostet wird, sind sie auf automatisierte Werkzeuge angewiesen, um verschiedene Kategorien illegaler oder potenziell schädlicher Inhalte zu finden und zu bekämpfen. Insbesondere dominante Akteure wie Facebook und Google haben Überwachungs- und Filtertechnologien zur Identifizierung und Entfernung von Inhalten eingesetzt. Sind wir uns einig über die Entfernung von Material über Kindesmissbrauch, indem wir der Polizei erlauben, Verbrechen zu untersuchen? Sicherlich. Sind wir gegen die dauerhafte Löschung von Inhalten, die ansonsten als wichtige Beweise und Unterlagen für grobe Menschenrechtsverletzungen sowie Kriegsverbrechen dienen würden? Auf jeden Fall.

Die EU hat zusammen mit einigen Mitgliedstaaten kontinuierlich darauf gedrängt, dass Online-Plattformen illegale oder potenziell schädliche Inhalte, wie z.B. Online-Hassreden oder Terrorismus, rasch entfernen, oft unter Androhung von Geldstrafen, wenn sie nicht schnell genug handeln. Um diesen Anforderungen gerecht zu werden, sind Technologieunternehmen auf automatisierte Werkzeuge angewiesen, um Informationen herauszufiltern, die nicht online gehen sollten.

Während die Automatisierung für die Handhabung einer großen Menge von Inhalten, die von den Benutzern gemeinsam genutzt werden, notwendig ist, macht sie Fehler, die für Ihre Rechte und das Wohlergehen der Gesellschaft weitreichend sein können.

Die kontextuelle Blindheit der automatisierten Maßnahmen bringt die legitime Sprache zum Schweigen

Automatisierten Entscheidungshilfen fehlt das Verständnis für sprachliche oder kulturelle Unterschiede. Technologien zur Inhaltserkennung sind nicht in der Lage, den Kontext von Ausdrücken genau zu beurteilen. Selbst in einfachen Fällen produzieren sie falsche Übereinstimmungen. Im Jahr 2017 strahlte der Popstar Ariana Grande ihr Benefizkonzert „One Love Manchester“ über ihren YouTube-Kanal aus. Der Stream wurde prompt vom YouTube-Upload-Filter abgeschaltet, der die Show von Grande fälschlicherweise als Verletzung ihres eigenen Urheberrechts kennzeichnete. Noch schlimmer: Dieselben automatisierten Tools entfernten Tausende von YouTube-Videos, die als Beweise für Gräueltaten gegen die Zivilbevölkerung in Syrien dienen könnten, was eine zukünftige Untersuchung von Kriegsverbrechen gefährden könnte, die Kriegsverbrecher vor Gericht bringen könnte. Aufgrund ihrer kontextuellen Blindheit oder, mit anderen Worten, ihrer Unfähigkeit, die wahre Bedeutung und die Absichten der Benutzer zu verstehen, kennzeichnen und entfernen sie Inhalte, die völlig legitim sind. So riskieren Journalisten, Aktivisten, Komödianten, Künstler sowie jeder von uns, der seine Meinungen und Videos oder Bilder online teilt, dass sie zensiert werden, weil sich Internetfirmen auf diese schlecht funktionierenden Werkzeuge verlassen.

Sie sind keine Wunderwaffe

Diese Technologien werden manchmal als „Künstliche Intelligenz“ (KI) bezeichnet, ein Begriff, der Vorstellungen von übermenschlicher rechnergestützter Intelligenz hervorruft. Allerdings existiert nichts dergleichen und ist auch nicht am Horizont zu sehen. Stattdessen bezieht sich dieser Begriff auf fortgeschrittene statistische Modelle, die darauf trainiert wurden, Muster zu erkennen, aber ohne tatsächliches „Verständnis“ oder „Intelligenz“. Technologien zur Erkennung von Inhalten können die Bedeutung oder Absicht derjenigen, die einen Beitrag in sozialen Medien teilen, oder die Auswirkungen, die dieser Beitrag auf andere hat, nicht verstehen. Sie scannen den Inhalt lediglich nach bestimmten Mustern wie visuellen, verbalen oder Audiodateien, die dem entsprechen, was sie als „Hassrede“ oder „terroristische Inhalte“ zu erkennen gelernt haben. Es gibt keine perfekten, eindeutigen Trainingsdaten, und daher ist ihre Fähigkeit, diese Muster zu erkennen, von Natur aus auf das beschränkt, was sie zu erkennen gelernt haben. Obwohl sie bei der Identifizierung eindeutiger, konsistenter Muster ein sehr hohes Maß an Genauigkeit erreichen können, wird ihre Fähigkeit, die sehr heikle Aufgabe der Beurteilung, ob etwas Hassreden sind, zu automatisieren, immer grundlegend eingeschränkt sein.

Verständlicherweise wollen Regierungen ihren Bürgern zeigen, dass sie etwas tun, um uns vor Terrorismus, Hassreden, Kindesmissbrauch oder Urheberrechtsverletzungen zu schützen. Und Unternehmen sind sehr froh, ihre Automatisierungstechnologien als eine Wunderlösung an Politiker zu verkaufen, die verzweifelt nach einer einfachen Antwort suchen. Aber wir müssen uns vor Augen halten, dass keine Automatisierung die in unserer Gesellschaft tief verwurzelten Probleme lösen wird. Wir können sie als Mittel zur Verringerung der Belastung von Plattformen einsetzen, aber wir brauchen Schutzmaßnahmen, die sicherstellen, dass wir unsere Menschenrechtsfreiheit nicht wegen schlecht ausgebildeter automatisierter Werkzeuge opfern.

Wer sollte also entscheiden, was wir online sehen? Lesen Sie den nächsten Teil dieser Serie in der nächsten Ausgabe des EDRi-gram-Newsletters.

Weitere Informationen:

Wie viele Daten erstellen wir jeden Tag? Die überwältigenden Statistiken, die jeder lesen sollte (21.05.2018)

Ein menschenzentriertes Internet für Europa (19.02.2020)

Automatisierung und illegale Inhalte: Können wir uns darauf verlassen, dass Maschinen für uns Entscheidungen treffen? (17.02.2020)

Automatisierung und illegale Inhalte: Können wir uns darauf verlassen, dass Maschinen für uns Entscheidungen treffen? (17.02.2020)

Beitrag von Eliška Pírková, EDRi-Mitglied Access Now, und Eva Simon, Civil Liberties Union for Europe

Deutsche Übersetzung der englischsprachigen Originalbeiträge von EDRi von Lutz Martiny

0 Kommentare zu “EDRi-gram 18.4, 26. Februar 2020”